آنتروپی اطلاعات

آنتروپی در نظریه اطلاعات معیاری عددی از میزان اطلاعات یا میزان تصادفی بودن یک متغیر تصادفی است. به بیان دقیقتر آنتروپی یک متغیر تصادفی، مقدار متوسط (امید ریاضی) میزان اطلاعات حاصل از مشاهدهٔ آن است (به عبارت ساده تر هرچه آنتروپی یک متغیر تصادفی بیشتر باشد ابهام ما در مورد آن متغیر تصادفی بیشتر می باشد لذا با مشاهده نتیجه قطعی آن متغیر تصادفی اطلاعات بیشتری بدست می آید پس هرچه آنتروپی یک متغیر تصادفی بیشتر باشد اطلاعات حاصل از مشاهده قطعی آن بیشتر خواهد بود) همچنین آنتروپی یک منبع اطلاعات، حد پایین امید بهترین نرخ فشردهسازی بدون اتلاف دادهها برای آن منبع است.

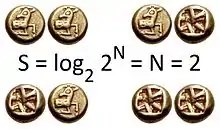

اطلاعات حاصل از مشاهده یک رویداد برابر با منفی لگاریتم احتمال رخ دادن آن تعریف میشود؛ بهطور طبیعی از هر تابع مناسب برای سنجش میزان اطلاعات یک مشاهده انتظاراتی وجود دارد، شامل اینکه اطلاعات حاصل از یک مشاهده مقداری نامنفی باشد. اطلاعات حاصل از مشاهدهٔ یک رویداد قطعی (یعنی با احتمال یک) صفر باشد و مهمتر از همه اطلاعات حاصل از دو مشاهدهٔ مستقل برابر با جمع اطلاعات حاصل از مشاهدهٔ تک تک آنها باشد. میتوان نشان داد تنها تابعی که سه ویژگی فوق را ارضاء میکند تابع منفی لگاریتم احتمال است. میزان اطلاعات با پایههای مختلف لگاریتم تنها یک ضریب ثابت با هم اختلاف دارد. متداولترین پایهٔ لگاریتم در محاسبهٔ اطلاعات ۲ است که اطلاعات را در واحد بیت یا شانون محاسبه میکند.

بهطور کلی در علوم و مهندسی، آنتروپی معیاری از میزان ابهام یا بینظمی است. کلود شانون در مقالهٔ انقلابی خود با نام «A Mathematical Theory of Communication» در سال ۱۹۴۸، آنتروپی شانون را معرفی کرد و پایهگذار نظریهٔ اطلاعات شد.

تعریف

آنتروپی متغیر تصادفی گسستهٔ با تابع جرم احتمال را با نماد نمایش میدهند و به صورت زیر تعریف میشود:

در رابطهٔ بالا تابع امید ریاضی و تابع میزان اطلاعات رویداد است. تابعی از یک متغیر تصادفی و در نتیجه یک متغیر تصادفی است. پایهٔ لگاریتم است و مقادیر مختلف آن آنتروپی را در واحدهای متفاوتی محاسبه میکند. متداولترین مقادیر برای ، ۲ و e و ۱۰ هستند که به ترتیب آنتروپی را در واحدهای بیت و nat و hartley محاسبه میکند.

میتوان آنتروپی را به صورت باز هم نوشت:

همچنین مقدار را صفر تعریف میکنیم که با مشاهدهٔ نیز سازگار است.

آنتروپی متغیر تصادفی به شرط با توزیع احتمال مشترک نیز به صورت زیر تعریف میشود:

میانگین اطلاعات حاصل از مشاهدهٔ به شرط اطلاع از را نشان میدهد.

مثال

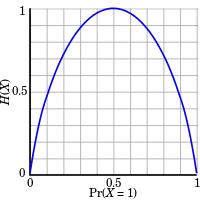

متغیر تصادفی را برابر با نتیجهٔ پرتاب یک سکه در نظر بگیرید که با احتمال شیر و با احتمال خط میآید. هرچقدر به نزدیکتر باشد، ابهام در مورد نتیجهٔ پرتاب بیشتر است و به همین ترتیب اطلاع از نتیجهٔ پرتاب بهطور میانگین اطلاعات بیشتری دربردارد. در واقع بیشترین میزان آنتروپی برای حالت و برابر با ۱ بیت است:

در حالتی که صفر یا یک باشد، هیچ ابهامی در مورد نتیجهٔ پرتاب وجود ندارد و به همین ترتیب اطلاع از نتیجهٔ پرتاب هیچ اطلاعاتی در برندارد:

برای حالت انتظار داریم آنتروپی کمتر از حالت یکنواخت و بیشتر از حالت بدون ابهام باشد:

بهطور کلی بیشترین میزان آنتروپی برای یک متغیر تصادفی در توزیع یکنواخت و کمترین میزان آنتروپی در توزیعی با یک رویداد قطعی رخ میدهد.

فشردهسازی دادهها

آنتروپی یک منبع اطلاعات، حد پایین متوسط بهترین نرخ فشردهسازی بدون اتلاف دادههای آن منبع است. به بیان دقیقتر هیچ روش فشردهسازی ای وجود ندارد که بهطور میانگین مقدار متغیر تصادفی را با کمتر از بیت فشرده کند. این حد پایین بسیار قوی است، بهطوری که برای دنبالههای به طول از دادههای هر منبع تصادفی ، یک روش فشردهسازی وجود دارد که بهطور میانگین، نتیجه هر مشاهده را حداکثر با بیت فشرده میکند.