پسانتشار

پسانتشار[1] (انگلیسی: Backpropagation) یا انتشار معکوس، روشی در یادگیری عمیق شبکههای عصبی مصنوعی، با بیش از یک لایه پنهان است، که برای محاسبه دقیق تر گرادیان وزن مورد استفاده قرار میگیرد. این روش اغلب با بهینهسازی الگوریتم یادگیری و تثبیت وزن نورونها با محاسبه گرادیان کاهشی تابع هزینه انجام میگیرد. این الگوریتم همچنین برای شبکه عصبی پیشخور که نیاز به یادگیری با نظارت دارند، نیز استفاده میشود.[2]

ساختار ریاضی الگوریتم

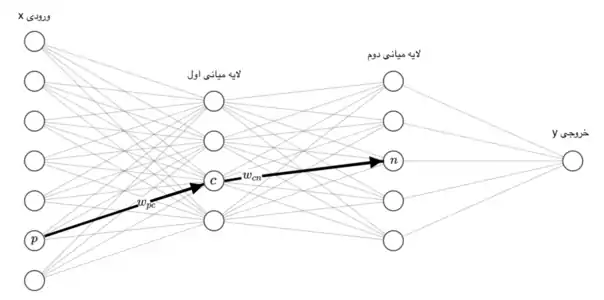

برای سلول عصبی ورودیی که از سلول عصبی به این سلول وارد میشود را با نشان میدهیم. وزن این ورودی است و مجموع ضرب ورودیها با وزنهایشان را با نمایش میدهیم، یعنی . حال باید بر روی یک تابع غیر خطی اعمال کنیم، این تابع را مینامیم و خروجی آن را با نمایش میدهیم به این معنی که . به همین شکل خروجیهایی که از سلول عصبی خارج شده و به سلول وارد میشوند را با نمایش میدهیم و وزن آن را با . اگر تمام وزنهای این شبکه عصبی را در مجموعهای به اسم بگنجانیم، هدف در واقع یادگیری این وزنهاست.[3] اگر ورودی ما باشد و خروجی و خروجی شبکه عصبی ما ، هدف ما پیدا کردن است به قسمی که برای همه دادهها و به هم خیلی نزدیک شوند. به عبارت دیگر هدف کوچک کردن یک تابع ضرر بر روی تمام داده هاست، اگر دادهها را با و تابع ضرر را با نشان دهیم هدف کمینه کردن تابع پایین بر حسب است:[4]

به عنوان مثال اگر مسئله رگرسیون است برای میتوانیم خطای مربعات را در نظر بگیریم و اگر مسئله دستهبندی است برای میشود منفی لگاریتم بازنمایی را استفاده کرد.

برای بدست آوردن کمینه میتوان از روش گرادیان کاهشی استفاده کرد، به این معنی که گرادیان تابع را در حساب کرد و کمی در خلاف جهت آن حرکت کرد و این کار را آنقدر ادامه داد تا تابع ضرر خیلی کوچک شود. روش بازگشت به عقب در واقع روشی برای پیدا کردن گرادیان تابع است.

حال فرض کنیم میخواهیم گرادیان تابع را نسبت به وزن بدست بیاوریم. برای این کار نیاز به قاعده زنجیری در مشتقگیری داریم. قاعده زنجیری به این شکل کار میکند: اگر تابعی داشته باشیم به اسم که وابسته به سه ورودی ، و باشد و هرکدام از این سه ورودی به نوبه خود وابسته به باشند، مشتق به به این شکل محاسبه میشود:

با استفاده از این قاعده زنجیری روش بازگشت به عقب را به این شکل دنبال میکنیم:

همانطور که در خط پیشین دیدیم برای بدست آوردن گرادیان نسبت به به دو مقدار نیاز داریم ورودی به سلول عصبی از سلول عصبی که همان است و راحت بدست میآید و که از روش بازگشتی بدست میآید و بستگی به آن هایی لابه بعد دارد که سلول به آنها وصل است، بهطور دقیقتر .

روش بازگشتی برای بدست آوردن ها به این شکل کار میکند که ابتدا را برای سلولهای لایه خروجی حساب میکنیم، و بعد لایهها را به نوبت پایین میروم و برای هر سلول آن را با ترکیت های لایههای بالایی آن طبق فرمول حساب میکنیم. محاسبه کردن برای لایه خروجی آسان است و مستقیماً با مشتق گرفتن از بدست میآید.[5]

جستارهای وابسته

منابع

- مقایسه دو الگوریتم پس انتشار خطا و ژنتیک در یادگیری شبکه عصبی برای پیشبینی سری زمانی آشوبگونه. زهرا عربسرخی، محمدرضا اصغری اسکویی

- «Build with AI | DeepAI». DeepAI. بایگانیشده از اصلی در 17 اكتبر 2018. دریافتشده در 2018-10-24. تاریخ وارد شده در

|archivedate=را بررسی کنید (کمک) - A., Nielsen, Michael (2015). "Neural Networks and Deep Learning". Archived from the original on 22 اكتبر 2018. Retrieved 23 اكتبر 2018. Check date values in:

|access-date=, |archive-date=(help) - A., Nielsen, Michael (2015). "Neural Networks and Deep Learning". Archived from the original on 22 اكتبر 2018. Retrieved 23 اكتبر 2018. Check date values in:

|access-date=, |archive-date=(help) - Russell, Stuart; results, search (2009-12-11). Artificial Intelligence: A Modern Approach (به English) (3 ed.). Boston Columbus Indianapolis New York San Francisco Upper Saddle River Amsterdam, Cape Town Dubai London Madrid Milan Munich Paris Montreal Toronto Delhi Mexico City Sao Paulo Sydney Hong Kong Seoul Singapore Taipei Tokyo: Pearson. p. 578. ISBN 9780136042594.

- مشارکتکنندگان ویکیپدیا. «Backpropagation». در دانشنامهٔ ویکیپدیای انگلیسی، بازبینیشده در ۲۹ آوریل ۲۰۱۸.